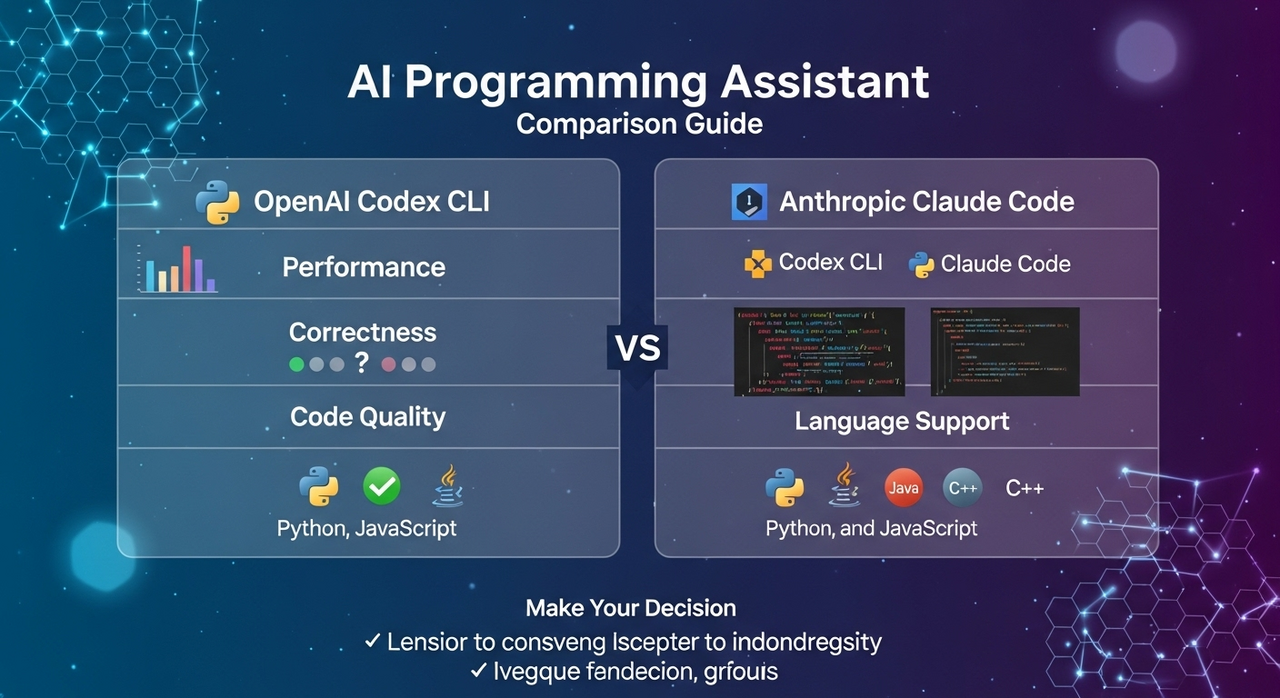

在 AI 程式助手領域,OpenAI Codex CLI 與 Anthropic Claude Code 都能自動生成程式碼、協助除錯、理解自然語言指令。本文整合四大面向的比較(效能、正確性、程式碼品質、語言支援),並提供「使用者角度」的選擇指南,最後附上可查證的參考資料。

📊 總覽比較表

| 面向 | Codex CLI(OpenAI) | Claude Code(Anthropic) |

|---|---|---|

| 效能(互動速度) | 偏重深入推理,複雜任務時回應較慢,但對艱難問題更周延。[1] | 多數實測認為回應更快、互動更順暢。[2] |

| 正確性(程式可執行度) | 在高難度任務與深度推理上表現突出;多項綜合比較顯示具領先力案例。[1][4] | Anthropic 與雲端平台公布新版在 SWE-bench Verified 等基準有明顯進步與領先案例。[3][9] |

| 程式碼品質 | 偏「完整嚴謹」與邊界處理周全;但有時略顯冗長或工程化。[2] | 偏「簡潔可讀、常帶註解」,易於維護;偶爾為了簡潔未面面俱到。[2] |

| 語言支援 | 主流語言(Python/Java/JS/C++)表現強,對小眾或進階特性(如 Rust/Haskell/Julia)也有深度;CLI 能在本機讀/改/跑程式。[6][7] | 主流語言支援成熟;整體語言覆蓋廣,且新版在實務軟工基準強化明顯。[8][3] |

| 長上下文能力 | OpenAI 文件與頁面說明 GPT-4o/4.1 的長上下文能力與模型定位。[10][11] | Claude 3.5 Sonnet 對外說明提供大型上下文視窗,利於大型代碼庫工作。[8] |

⚡ 效能(互動速度)

多數第三方與媒體實測指出:Claude 在互動上更即時,回覆順暢,對迭代式開發與「問—改—再跑」的迴圈更友善;而 Codex / OpenAI 的高推理模型則傾向花較多時間在 deliberate(思考),在極複雜情境上較周延,但體感速度可能慢一些。[1][2]

🎯 正確性(是否能跑、少改動)

兩者在標準編碼基準(如 HumanEval)與實務基準(如 SWE-bench Verified)的表現都屬第一梯隊。雲端平台與官方研究指出 Claude 3.5 Sonnet 在 SWE-bench Verified 由 ~33% 提升至 ~49% 的案例;也有獨立分析比較 OpenAI o1 系列 在多項綜合基準具領先力。[3][9][4]

📝 程式碼品質(可讀性、註解、結構)

- Codex / OpenAI: 產出偏「完整嚴謹、邏輯與邊界處理徹底」,適合嚴肅專案;但有時顯得冗長或過度工程化。[2]

- Claude: 產出傾向「簡潔、可讀、常帶註解」,易於維護與團隊接力;偶爾為了簡潔未面面俱到。[2]

🌐 語言支援

兩者對主流語言(Python、Java、JavaScript、C++)都成熟;OpenAI 在小眾或進階特性領域常被認為深度更足;Claude 也能處理多數語言與常見框架。Codex CLI 本身是能在本機「讀、改、跑」你的程式碼的命令列代理,對既有專案的實作與除錯很實用。[6][7]

👤 使用者角度選擇指南

1) 學生/自學者

推薦:Claude — 程式碼簡潔、常附註解、互動速度快,適合學習與理解。

2) 專業工程師(嚴謹專案)

推薦:Codex / OpenAI — 偏重深入推理與完整邊界處理,適合高複雜度與上線場景。

3) 新創/快速原型

推薦:Claude — 互動快、程式碼乾淨,團隊接力與迭代更順手。

4) 資深開發者(棘手 Bug/深度設計)

推薦:Codex / OpenAI — 更願意花時間「思考」以找出邏輯漏洞與邊界問題。

5) 資訊工作者/非全職工程師

推薦:Claude — 更容易生成「拿來即用」的腳本與範例。

📌 最後建議

- 日常開發、學習、快速原型 → 選 Claude

- 上線級專案、複雜工程、進階語言特性 → 選 Codex / OpenAI

- 雙刀流策略: 用 Claude 快速產出與迭代,用 OpenAI 做最終嚴謹性把關與複雜問題處理。

🔎 參考資料(可點擊)

- OpenAI:Introducing OpenAI o1(模型定位與推理特性);另見 o1-mini 發表。

- Tom’s Guide:ChatGPT-5 vs Claude Sonnet 4 程式任務實測(近期實測,著重可用性與速度)。

- AWS 官方部落格:Upgraded Claude 3.5 Sonnet(含 SWE-bench Verified 提升)。另見 About Amazon 新聞頁。

- 分析文章:Comparing OpenAI o1 to other top models(涵蓋多項基準比較與解讀)。

- Helicone:GPT-4o Mini vs Claude 3.5 Sonnet(另有 對照頁)。

- OpenAI 官方文件:Codex CLI 說明與安裝。

- 開源原始碼:openai/codex(Codex CLI 倉庫)。

- Anthropic 官方:Introducing Claude 3.5 Sonnet;另見 3.5 模型與 Computer Use 更新。

- Anthropic 研究頁:Claude 3.5 Sonnet SWE-bench Performance(Verified 提升到 ~49% 的案例)。

- OpenAI 模型頁:Codex 產品頁(含 CLI/IDE 整合);另見 OpenAI 平台模型頁關於 4o。

- OpenAI:The Verge:o1 發表新聞報導(補充背景)。

註:產業對基準測試的更新很頻繁(例如 SWE-bench Verified、HumanEval 與更實務的任務集正在演進),不同測試常得出不同結論;建議以你的實際語言/框架/代碼庫進行小型試跑再決策。

發佈留言